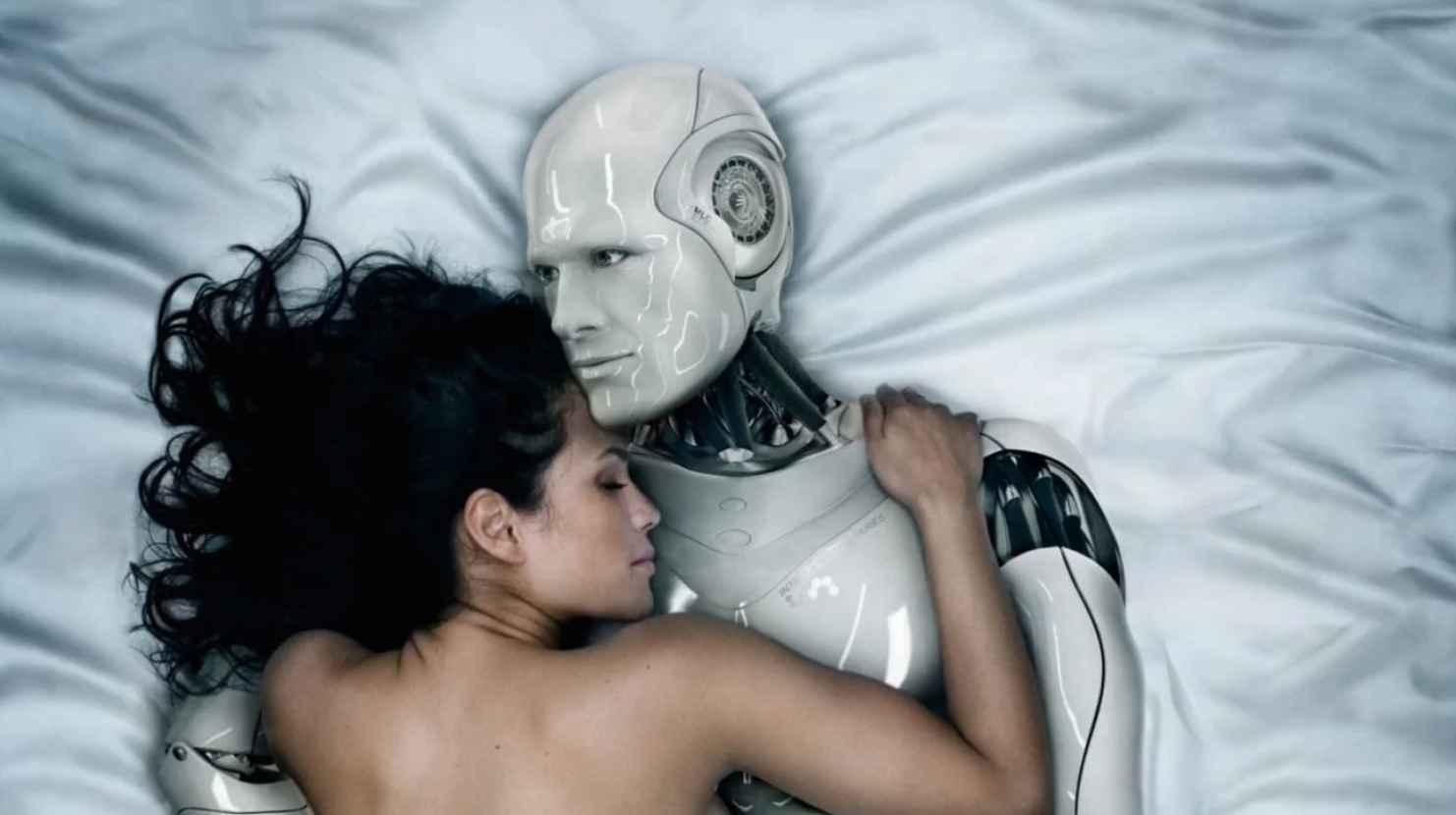

Вы сразу понимаете, что перед вами порно. А поймет ли компьютер?

В начале прошлого месяца Tumblr объявил, что будет банить порно. Когда новая политика в отношении контента вступила в силу, примерно через две недели — 17 декабря — стало очевидно, что будут проблемы. После развертывания системы искусственного интеллекта, которая должна была перебанить всю порнографию на сайте, она ошибочно пометила невинные посты в 455,4 миллиона блогах на сайте среди 168,2 миллиарда постов: вазы, ведьм, рыб и все такое прочее.

Порнография для искусственного интеллекта

Хотя непонятно, какой автоматический фильтр использовал Tumblr или создавал свой собственный — компания не ответила на запросы по этой теме — очевидно, что социальная сеть застряла между собственной политикой и технологиями. Например, непоследовательная позиция сайта в отношении «женщин, демонстрирующих соски» и художественной наготы, например, привела к контекстуальным решениям, которые демонстрируют, что даже Tumblr не знает, что запрещать у себя на платформе. Как частой компании определить, что она считает непристойным?

Во-первых, блокировать рискованный контент трудно, потому что изначально сложно определить, что это такое. Определение непристойности — медвежий капкан, которому больше ста лет, еще в 1896 году Соединенные Штаты впервые приняли законы, регулирующие непристойность. В 1964 году в деле Джакобеллиса против Огайо касательно того, может ли Огайо запретить показ фильма Луи Маля, Верховный суд выдал, наверное, самое знаменитое определение жесткой порнографии на сегодня: «Я не буду сегодня пытаться и дальше дать определение такого рода материалу, которое, как я понимаю, будет включено в стенографическое описание; и, возможно, мне никогда не удастся сделать это вразумительно», сказал судья Поттер Стюарт. «Но я знаю, что это такое, когда вижу, и кинофильм, связанный с этим делом, этим не является».

У алгоритмов машинного обучения та же проблема. Именно эту проблему пытается решить Брайан Делордж, CEO Picnix, компании, которая продает специализированную технологию искусственного интеллекта. Один из их продуктов — Iris — представляет собой приложение на стороне клиента, которое служит для обнаружения порнографии, чтобы «помочь людям», как говорит Делордж, «которые не хотят порно в своей жизни». Он отмечает, что отдельная проблема порно в том, что там может быть что угодно, куча разных вещей — и изображения, которые порнографическими не являются, могут иметь похожие элементы. Изображение вечеринки на пляже может быть заблокировано не потому, что на нем больше кожи, чем на фотографии в офисе, а потому что это на грани. «Вот почему очень трудно обучить алгоритм распознавания изображений всему сразу», говорит Делордж. «Когда определение становится сложным для людей, компьютер тоже сталкивается с трудностями». Если люди не могут договориться о том, что есть порно, а что нет, может ли компьютер вообще надеяться узнать разницу?

Для того, чтобы научить ИИ обнаруживать порно, первое, что вам нужно сделать, это скормить ему порно. Много порнографии. Где его взять? Ну, первое, что делают люди, это скачивают кучу видосов с Pornhub, XVideos, говорит Дэн Шапиро, соучредитель стартапа Lemay.ai, который создает фильтры ИИ для своих клиентов. «Это одна из тех серых областей правового характера — к примеру, если вы обучаетесь на контенте других людей, принадлежит ли он вам?».

После того, как программисты скачивают тонны порно, они вырезают из видео кадры, которые порнографией не являются, чтобы убедиться, что используемые кадры не приведут к блокировке разносчиков пиццы. Платформы платят людям, по большей части, за пределами США, за маркировку подобного контента; работа низкооплачиваемая и скучная, словно вводить «капчу». Они просто сидят и отмечают: это такое порно, это — вот это. Фильтровать приходится немного, потому что все порно выходит с маркировкой. Обучение идет лучше, если использовать не просто фотографии, а большие выборки данных.

«Зачастую приходится не просто фильтровать порно, а скорее сопутствующий материал», говорит Шапиро. «Вроде поддельных анкет с фотографией девушки и телефоном». Он имеет в виду секс-работниц в поиске клиентов, но это может быть что угодно, не совсем законное. «Это не порно, но такого рода вещей вы не хотите наблюдать на своей платформе, да?». Хороший автоматизированный модератор обучается на миллионах — если не десятках миллионов — примерах контента, а значит может сэкономить уйму человеко-часов.

«Можно сравнить это с разницей между ребенком и взрослым», говорит Мэтт Цейлер, генеральный директор и основатель Clarifai, стартапа из области компьютерного зрения, который осуществляет такую фильтрацию изображений для корпоративных клиентов. «Могу сказать вам точно — пару месяцев назад у нас был ребенок. Они не знают ничего о мире, для них все ново». Приходится показывать ребенку (алгоритму) много всякого, чтобы он что-то уяснил. «Миллионы и миллионы примеров. Но будучи взрослыми — когда мы создали так много контекста о мире и поняли, как он работает — мы можем узнавать что-то новое всего из пары примеров». (Да, обучить ИИ фильтровать контент для взрослых — это как показать ребенку много порно). Сегодня компании вроде Clarifai быстро растут. У них хорошая база данных о мире, они могут отличать собак от кошек, одетых от нагих. Компания Цейлера использует свои модели для обучения новых алгоритмов для своих клиентов — поскольку исходная модель обработала много данных, персональные версии потребуют лишь новых наборов данных для работы.

Тем не менее, алгоритму сложно все сделать правильно. С содержанием, которое очевидно порнографическое, он справляется хорошо; но классификатор может неправильно пометить объявление о нижнем белье как запретное, потому что на картинке больше кожи, чем, скажем, в офисе. (С бикини и нижним бельем, по словам Цейлера, очень сложно). Это значит, что люди, занимающиеся маркировкой, должны сосредоточиться на этих крайних случаях в своей работе, отдавая приоритет тому, что трудно классифицировать модели.

А что сложнее всего?

«Аниме-порно», говорит Цейлер. «Первая версия нашего детектора наготы не использовала для обучения мультяшную порнографию». Много раз ИИ плошал, потому что не распознавал хентай. «Поработав над этим для клиента, мы внедрили кучу его данных в модель и существенно улучшили точность фильтра мультипликационных картинок, сохранив точность реальных фотографий», говорит Цейлер.

Технология, которая научена вынюхивать порно, может использоваться и на других вещах. Технологии, лежащие в основе этой системы, удивительно гибкие. Это больше, чем анимешные сиськи. Jigsaw от Alphabet, например, широко используется в качестве автоматического модератора комментариев в газете. Это программное обеспечение работает аналогично классификаторам изображений, за исключением того, что сортирует по токсичности, а не по наготе. (Токсичность в текстовых комментариях определить так же трудно, как и порнографию на снимках). Facebook использует подобную автоматическую фильтрацию для выявления суицидальных сообщений и контента, связанного с терроризмом, и он пытался использовать эту технологию для обнаружения фейковых новостей на своей массивной платформе.

Все это по-прежнему зависит от человеческого надзора; мы лучше справляемся с неоднозначностью и двусмысленным контекстом. Цейлер говорит, что не думает, что его продукт лишил кого-нибудь работы. Он решает проблему масштабирования Интернета. Люди все так же будут обучать ИИ, сортируя и маркируя контент так, чтобы ИИ мог его различать.

Таково будущее модерации: индивидуальные, готовые решения, предоставляемые компании, которые делаю весь свой бизнес на обучении все более совершенных классификаторов большему количеству данных. Точно так же, как Stripe и Square предлагают готовые платежные решения для предприятий, которые не хотят обрабатывать их самостоятельно, стартапы вроде Clarifai, Picnix и Lemay.ai будут осуществлять онлайн-модерацию.

Дэн Шапиро из Lemay.ai полон надежд. «Как и в случае с любой другой технологией, она все еще в процессе изобретения. Поэтому я не думаю, что мы уступим в случае неудачи». Но сможет ли ИИ когда-нибудь действовать автономно без надзора человека? Непонятно. «Нет никакого маленького человечка в табакерке, который фильтрует каждый снимок», говорит он. «Нужно получать данные отовсюду, чтобы на них тренировать алгоритм».

Цейлер, с другой стороны, считает, что однажды искусственный интеллект будет модерировать все самостоятельно. В конце концов, количество вмешательств со стороны людей сведется к нулю, либо к незначительным усилиям. Постепенно усилия человека превратятся в то, что ИИ сейчас делать не может, вроде рассуждений высокого уровня, самосознания — всего, что есть у людей.

Распознавание порнографии является частью этого. Идентификация является относительно тривиальной задачей для людей, но гораздо сложнее обучить алгоритм распознавать нюансы. Определение порога, когда фильтр маркирует изображение как порнографическое или не порнографическое, тоже сложная задача, отчасти математическая.

Искусственный интеллект — это несовершенное зеркало того, как мы видим мир, точно так же, как порнография — это отражение того, что происходит между людьми, когда они остаются наедине. В нем есть доля правды, но полной картины — нет.